티스토리 뷰

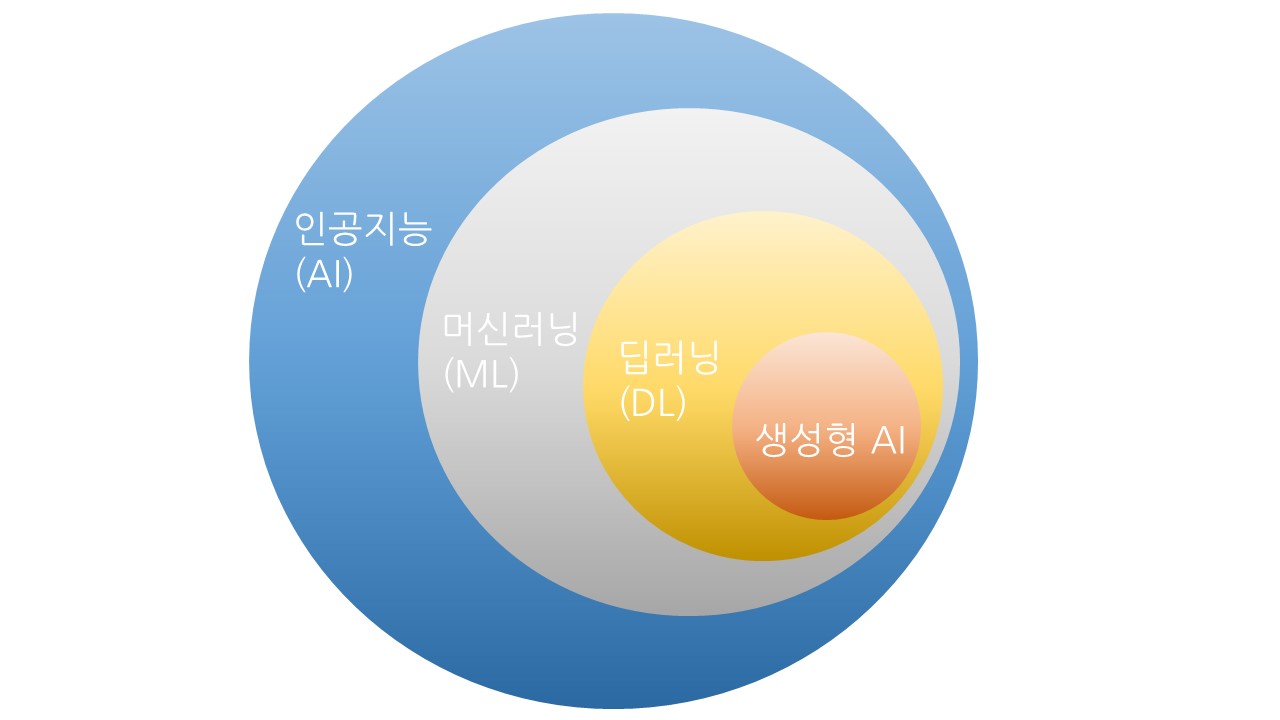

본 글은 생성형 AI pipeline 구축을 위한 데이터·학습·배포의 전 과정을 절차 중심으로 심화 정리합니다. 데이터 수집·정제·거버넌스, 모델 튜닝·평가·안전, 서빙 인프라·관측·자동화를 하나의 체계로 엮어 실패 확률을 낮추고 비용 대비 성능을 극대화하는 실무 가이드를 제공합니다.

데이터 아키텍처와 거버넌스 설계

pipeline의 상한은 데이터 레이어가 결정합니다. 수집 단계에서는 공개 코퍼스, 사내 지식(문서·코드·티켓·로그), 제삼자 라이선스 데이터로 출처를 분리하고, 각각에 대해 저작권·개인정보(PII)·기밀 등급을 정의해야 합니다. 정제는 중복 제거(MinHash/LSH), 언어·도메인 불균형 재가 중, 품질 필터링(저 정보량 문서·스팸·유해표현·광고 제거)으로 진행합니다. 표·코드·수식은 파서로 구조를 보존해 모델이 포맷을 학습하도록 전처리하고, 대화형 데이터는 턴 구조·역할(role) 라벨을 명확히 해야 합니다. 데이터 카드(Data Card)에는 출처, 제외 규칙, 품질 지표(고유 토큰 비율, n-gram 신규도, perplexity 분포), 언어/도메인 비율, 업데이트 주기를 기록하여 재현성을 담보합니다. 거버넌스는 라인리지와 삭제권 대응이 핵심입니다. 수집→정제→샘플링→학습 투입까지 해시 체인으로 추적하고, DSR(데이터 삭제 요청) 발생 시 원본·파생본·임베딩·백업에서 일관 삭제가 가능해야 합니다. 민감정보는 규칙+ML 하이브리드 마스킹을 적용하고, 내부망/VPC 격리·KMS 암호화·세분화된 IAM·감사 로그를 기본으로 합니다. 샘플링은 목적 가중치(예: 사내 Q&A 30%, 기술 문서 25%, 코드 15%, 대화 10%, 공개 백과 20%)를 설정하고, epoch별 셔플·문서 드롭아웃·데이터 다이어트로 과적합을 방지합니다. 합법성은 라이선스 스캔(SPDX, 변형 허용 여부), 크롤링 robots 규정 준수, 3rd 파티 사용조건을 문서로 남겨 분쟁을 예방합니다. 정량 검증은 소규모 프로빙 학습으로 시작합니다. 동일 하이퍼에 데이터 버전만 바꿔 손실 곡선, 검증 perplexity, 다운스트림 지표(정확·환각·포맷 준수)를 비교하고, Δ성능/라벨링 비용으로 ROI를 계산해 다음 수집 라운드를 결정합니다. RAG를 병행한다면 인덱싱 파이프라인(크롤링→정제→청킹→임베딩→업서트)을 분리 운영하고, 문서 메타데이터(출처·버전·유효기간·보안등급)를 스키마로 고정해 회수·갱신을 자동화합니다.

모델 튜닝·평가·안전 프레임워크(학습)

학습은 비용·성능·시간의 균형 문제입니다. 사내 도메인 적응은 대개 PEFT(LoRA/QLoRA)로 충분하며, 4/8-bit 가중치+NF4+double quant로 VRAM을 절감합니다. 컨텍스트 확장은 RoPE scaling·ALiBi를 검토하고, 긴 문맥 응답의 안정화를 위해 position interpolation과 chunk-aware 학습을 병행합니다. SFT(지도튜닝)는 고품질 지시/응답 쌍을 엄선해 1~3 epoch 내로 과적합을 피하고, 정책 정렬은 RLHF·DPO·ORPO 등으로 선택합니다. 수식·코드·표 포맷은 함수 호출/JSON 스키마를 명시해 포맷 위반을 감점하는 학습 신호를 줍니다. 평가 체계는 자동+인간 이중화가 기본입니다. 자동 지표는 태스크별로 구성합니다: 지식질의(F1/EM), 요약(ROUGE/BERTScore), 추론(흐름 일치, 단계 정합), 코드(pass@k), 수학(GSM8K류), 포맷(스키마 유효성률), 환각(근거 문서 대비 사실 위반율). 인간 평가는 유용성·정확·명료·톤·편향을 5점 척도로 다심사자 평가하고, Kendall τ로 합의도를 확인합니다. RAG는 레트리버(top-k, MMR, 재랭커)와 생성 단계를 분리 평가하여 병목을 식별합니다. 안전성은 입력·출력·모델 경로에 각각 방어막을 둡니다. 입력 단계는 프롬프트 방화벽(탈취·시스템 지침 노출 방지), 금칙어·PII 탐지, 길이 제한을 적용합니다. 모델 경로는 안전 정책을 레이블링한 안전튜닝 데이터로 추가 학습하고, 고위험 도메인(의료·법률·금융)은 거부/제한/전문가 연결 정책을 명시합니다. 출력 단계는 PII/저작권 검출기, 워터마킹·샘플링 제약, 근거 링크 강제 등으로 유출·환각 피해를 줄입니다. 레드팀 시나리오(탈옥, 프롬프트 주입, 데이터 추정 공격)와 카나리 프롬프트를 주기적으로 돌려 회귀를 조기 탐지합니다. 재현성과 비용 제어도 필수입니다. MLflow/W&B로 실험 메타데이터(데이터 버전·코드 커밋·하이퍼·체크포인트)를 기록하고, 스팟 인스턴스+체크포인트 세이빙+그라디언트 체크포인팅으로 실패 복구를 자동화합니다. 러닝레이트 스케줄(워밍업→코사인감쇠), 응답 길이용 loss weight, label smoothing 같은 세부 튜닝이 토큰 효율을 높입니다. 지연 비용이 큰 지식 영역은 RAG에 위임하고, 모델은 추론·포맷·안전 규칙 준수에 집중시키는 아키텍처가 비용 대비 성능이 우수합니다. 평가 대시보드 예시 지표: 사실 위반률, 포맷 오류율, 거부 적중률, 불쾌감 점수, PII 누락 탐지율, pass@1/5, p50/p95 지연, 토큰/요청당 비용, 재현 빌드 성공률.

서빙 인프라·관측·자동화 운영(배포)

배포는 지연·안정·보안을 동시에 충족해야 합니다. 초기에는 서버리스 API로 속도를 확보하고, 요청량/비용 임계지점에서 쿠버네티스+GPU로 전환하는 혼합 전략이 유효합니다. 자체 호스팅 시에는 컨테이너 이미지 표준화, 암호화된 모델 아티팩트, 온라인/배치/실험 노드풀 분리, 큐 기반 오토스케일(HPA+KEDA), 다중 AZ 배치를 기본으로 합니다. 멀티테넌시는 rate limit·큐 분리·리소스 쿼터로 소란 간섭을 차단합니다. 성능 최적화는 캐시가 핵심입니다. KV 캐시 재사용, 프롬프트 캐시, 임베딩 캐시, 정적 시스템 프롬프트 압축으로 토큰 낭비를 줄이고, 긴 문맥은 슬라이스+요약·메모리 슬롯 기법으로 지연을 낮춥니다. RAG 파이프라인은 Airflow/Dagster로 스케줄링하고, 임베딩/검색 백엔드는 벡터 DB(FAISS/ScaNN/pgvector/매니지드) 중 워크로드에 맞게 선택합니다. 인덱스는 TTL·버전 태깅으로 롤백 가능하게 운영합니다. 관측 가능성(Observability)은 품질까지 포함해야 합니다. 요청·응답·토큰·지연·오류율을 수집하고, 샘플링된 응답을 자동·인간 평가로 점검하여 품질 신호(사실 위반·편향·금칙어 통과)를 대시보드화합니다. 임베딩 분포·쿼리 토픽 변화로 데이터 드리프트를 감지하고 임곗값 초과 시 재인덱싱·재튜닝 워크플로를 자동 트리거합니다. A/B·카나리·Blue-Green 배포로 회귀를 최소화하고, 1 클릭 롤백을 준비합니다. SLO는 가용성, p95 지연, 품질 KPI(사실 위반율, 포맷 오류율)로 정의하고 위반 시 런북에 따라 알림→자동 스케일→모델 폴백 순으로 대응합니다. 보안·컴플라이언스는 프롬프트·모델·데이터 경로 모두에서 요구됩니다. 비속어/PII 필터, 레이트 리미트, 테넌트 격리, 감사 로그 보관, 접근권한 최소화, 비상 토큰 차단, 키 롤링을 지속 운용합니다. 결제·의료 등 규제 산업은 로깅 보존기간, 데이터 지역성, 고객 분리 저장을 계약에 반영합니다. 비용 관리는 토큰/요청당 단가, GPU 사용률, 캐시 적중률, 재시도 비율을 핵심 지표로 삼고, 월 상한·알림·쿼터로 폭증을 방지합니다. 장애 대응 플레이북(모델 응답 품질 급락, 지연 급증, 캐시 장애, 인덱스 손상, RPS 스파이크)을 팀 전원이 주기적으로 드릴해야 합니다. 운영 체크리스트: SLA/SLO 정의 → 카나리 배포 → 토큰·지연·품질 모니터링 → 경보·폴백 자동화 → 보안 필터·레이트 리미트 → 비용 가드레일 → 인덱스 버저닝 → 런북/플레이북 업데이트. 요약하면, 생성형 AI pipeline은 데이터 합법성·품질·보안, 모델 효율·평가·안전, 서빙 성능·관측·자동화를 하나의 표준 절차로 묶을 때 비로소 확장성과 지속성을 얻습니다.